Bit (Informationstheorie)

- Bit (Informationstheorie)

-

|

Die Artikel Informationstheorie, Shannon-Index und Shannon (Einheit) überschneiden sich thematisch. Hilf mit, die Artikel besser voneinander abzugrenzen oder zu vereinigen. Beteilige dich dazu an der Diskussion über diese Überschneidungen. Bitte entferne diesen Baustein erst nach vollständiger Abarbeitung der Redundanz. Engelbaet 13:31, 14. Mai 2008 (CEST) |

Shannon (Sh) ist die nach dem amerikanischen Mathematiker und Begründer der Informationstheorie Claude Elwood Shannon benannte Hinweis-Einheit für den Informationsgehalt einer Nachricht.

Definition

Ein Shannon ist die theoretische minimale Anzahl an Bit, mit der eine Information abgebildet werden kann. Dabei ist der Informationsgehalt eines Signals abhängig von der Wahrscheinlichkeit, mit der das Signal an dieser Stelle auftritt – und damit umgekehrt proportional zur Entropie der Zeichenfolge.

Es geht hierbei nicht darum, wie viele reale Bits (bei einer gegebenen Kodierung) notwendig sind, um die Nachricht zu übertragen oder zu speichern, weshalb der Informationsgehalt eine reelle Zahl sein kann. Ein Aufrunden zur nächsten ganzen Zahl ist also nicht notwendig, sondern nimmt im Gegenteil der Angabe des Informationsgehaltes sogar Aussagekraft (und somit Informationsgehalt).

Diese Einheit wurde geschaffen, um die vorher verwendete Informationseinheit bit zu ersetzen, weil deren Benutzung Anlass für Verwechslungen mit dem Begriff Bit gibt. Das traditionell benutzte bit soll hierbei per Konvention klein geschrieben werden, um eine Unterscheidung zu Bit zu ermöglichen, was jedoch in der Praxis häufig nicht beachtet wird.

Beispiel

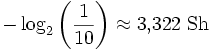

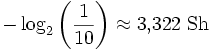

Wird in einer Nachricht nur eine Dezimalstelle übertragen, wobei das Auftreten jeder der zehn Ziffern gleich wahrscheinlich sei, so werden theoretisch  benötigt, um die Information einer Dezimalziffer darzustellen. Der Informationsgehalt dieser Nachricht beträgt also 3,322 Shannon. Die Datenmenge hingegen, die benötigt wird um diesen Informationsgehalt darzustellen, beträgt mindestens 4 Bit (3,322 aufgerundet). Die Darstellung mit den minimalen 4 Bit gelingt zum Beispiel durch Verwendung eines BCD-Codes.

benötigt, um die Information einer Dezimalziffer darzustellen. Der Informationsgehalt dieser Nachricht beträgt also 3,322 Shannon. Die Datenmenge hingegen, die benötigt wird um diesen Informationsgehalt darzustellen, beträgt mindestens 4 Bit (3,322 aufgerundet). Die Darstellung mit den minimalen 4 Bit gelingt zum Beispiel durch Verwendung eines BCD-Codes.

Normung

Normen zu Einheiten des Entscheidungsgehalts in der Informationstheorie findet man in IEC 60027-3 oder ISO 2382-16. Dort ist neben der auf dem Logarithmus zur Basis 2 beruhenden Einheit Shannon (Einheitenzeichen: Sh) noch das auf dem Zehner-Logarithmus beruhende Hartley (Einheitenzeichen: Hart) und die auf dem natürlichen Logarithmus beruhende natürliche Informationseinheit (Einheitenzeichen: nat) erklärt.

Wikimedia Foundation.

Schlagen Sie auch in anderen Wörterbüchern nach:

Informationstheorie — In|for|ma|ti|ons|the|o|rie 〈f. 19; unz.〉 Lehre über die quantitativen Zusammenhänge bei Übertragung, Speicherung u. Empfang von Informationen * * * I Informationstheorie, von dem amerikanischen Mathematiker C. E. Shannon 1948 begründete… … Universal-Lexikon

Informationstheorie — Die Informationstheorie ist eine mathematische Theorie aus dem Bereich der Wahrscheinlichkeitstheorie und Statistik, die auf Claude Shannon zurückgeht. Sie beschäftigt sich mit Begriffen wie Information, Entropie, Informationsübertragung,… … Deutsch Wikipedia

BIT — Der Ausdruck Bit bezeichnet die kleinste Einheit der Information; siehe Bit. veraltet für die Einheit des Informationsgehaltes in der Informationstheorie; siehe Shannon (Einheit). ein Kurzwort für Bier der Bitburger Brauerei. einen… … Deutsch Wikipedia

Bit/s — Die Datenübertragungsrate (auch Datentransferrate, Datenrate oder umgangssprachlich Verbindungsgeschwindigkeit, Übertragungsgeschwindigkeit, und nicht ganz zutreffend auch „Kapazität“, „Bandbreite“ genannt) bezeichnet die digitale Datenmenge, die … Deutsch Wikipedia

Bit Rate — Die Datenübertragungsrate (auch Datentransferrate, Datenrate oder umgangssprachlich Verbindungsgeschwindigkeit, Übertragungsgeschwindigkeit, und nicht ganz zutreffend auch „Kapazität“, „Bandbreite“ genannt) bezeichnet die digitale Datenmenge, die … Deutsch Wikipedia

Bit pro Sekunde — Die Datenübertragungsrate (auch Datentransferrate, Datenrate oder umgangssprachlich Verbindungsgeschwindigkeit, Übertragungsgeschwindigkeit, und nicht ganz zutreffend auch „Kapazität“, „Bandbreite“ genannt) bezeichnet die digitale Datenmenge, die … Deutsch Wikipedia

Entropie (Informationstheorie) — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Das… … Deutsch Wikipedia

Information — Schalter; Auskunftsschalter; Auskunft; Info (umgangssprachlich); Nachrichtengehalt; Mitteilung; Nachrichteninhalt; Daten; Datenansammlung; Fakten; … Universal-Lexikon

Überraschungswert — Der Begriff der Information, wie er in der Informationstheorie nach Shannon[1] verwendet wird, ist streng von dem gewöhnlichen Gebrauch dieses Begriffes zu unterscheiden. Insbesondere darf darin die Information nicht mit dem Begriff der Bedeutung … Deutsch Wikipedia

Informationsdichte — Entropie ist ein Maß für den mittleren Informationsgehalt oder auch Informationsdichte eines Zeichensystems. Der Begriff in der Informationstheorie ist in Analogie zur Entropie in der Thermodynamik und Statistischen Mechanik benannt. Beide… … Deutsch Wikipedia

benötigt, um die Information einer Dezimalziffer darzustellen. Der Informationsgehalt dieser Nachricht beträgt also 3,322 Shannon. Die Datenmenge hingegen, die benötigt wird um diesen Informationsgehalt darzustellen, beträgt mindestens 4 Bit (3,322 aufgerundet). Die Darstellung mit den minimalen 4 Bit gelingt zum Beispiel durch Verwendung eines BCD-Codes.

benötigt, um die Information einer Dezimalziffer darzustellen. Der Informationsgehalt dieser Nachricht beträgt also 3,322 Shannon. Die Datenmenge hingegen, die benötigt wird um diesen Informationsgehalt darzustellen, beträgt mindestens 4 Bit (3,322 aufgerundet). Die Darstellung mit den minimalen 4 Bit gelingt zum Beispiel durch Verwendung eines BCD-Codes.