Verfahren des steilsten Abstiegs

- Verfahren des steilsten Abstiegs

-

Das Verfahren des steilsten Abstiegs, auch Gradientenverfahren genannt, ist ein Verfahren, das in der Numerik eingesetzt wird, um allgemeine Optimierungsprobleme zu lösen. Dabei geht man (am Beispiel eines Minimierungsproblemes) von einem Näherungswert aus. Von diesem schreitet man in Richtung des negativen Gradienten (der die Richtung des steilsten Abstiegs von diesem Näherungswert angibt) fort, bis man keine numerische Verbesserung mehr erzielt.

Das Verfahren konvergiert oftmals sehr langsam, da es sich dem Optimum entweder mit einem starken Zick-Zack-Kurs nähert oder der Betrag des Gradienten in der Nähe des Optimums sehr klein ist, wodurch die Länge der Iterationsschritte dann ebenfalls sehr klein ist. Für die Lösung von symmetrisch positiv definiten linearen Gleichungssystemen bietet das Verfahren der konjugierten Gradienten hier eine immense Verbesserung. Der Gradientenabstieg ist dem Bergsteigeralgorithmus (hill climbing) verwandt.

Beschreibung des Verfahrens

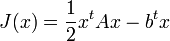

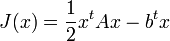

Typischerweise wird ein Energiefunktional der Form

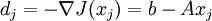

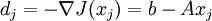

minimiert. Dabei ist A eine symmetrisch positiv definite Matrix. Ausgehend von einem Anfangspunkt x0 wird die Richtung des steilsten Abstiegs natürlich durch die Ableitung  bestimmt, wobei

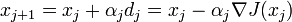

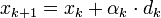

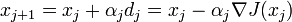

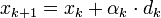

bestimmt, wobei  den Nabla-Operator bezeichnet. Dann wird wie folgt iteriert

den Nabla-Operator bezeichnet. Dann wird wie folgt iteriert

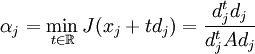

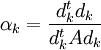

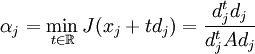

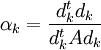

αj bezeichnet die Schrittweite des Verfahrens und kann durch

berechnet werden. Das Verfahren konvergiert dann für einen beliebigen Startwert gegen einen Wert x * , so dass J(x * ) minimal ist.

Algorithmus in Pseudocode

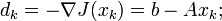

Eingabe: geeigneter Startvektor

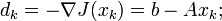

For k = 0 To n

end

Ausgabe: Minimum des Energiefunktionals.

Konvergenzgeschwindigkeit

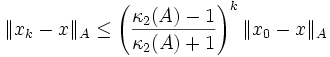

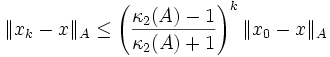

Das Gradientenverfahren liefert eine Folge  mit

mit

Dabei bezeichnet κ2 die Kondition der Matrix A. Das Verfahren konvergiert allerdings oftmals sehr langsam, da es sich dem Optimum entweder mit einem starken Zick-Zack-Kurs nähert oder der Betrag des Gradienten in der Nähe des Optimums sehr klein ist, wodurch die Länge der Iterationsschritte dann ebenfalls sehr klein ist. Für die Lösung von linearen Gleichungssystemen bietet das CG-Verfahren hier eine immense Verbesserung.

Literatur

- Andreas Meister: Numerik linearer Gleichungssysteme. 2. Auflage. Vieweg, Wiesbaden 2005, ISBN 3-528-13135-7.

Wikimedia Foundation.

Schlagen Sie auch in anderen Wörterbüchern nach:

Verfahren der konjugierten Gradienten — Ein Vergleich des einfachen Gradientenverfahren mit optimaler Schrittlänge (in grün) mit dem CG Verfahren (in rot) für die Minimierung der quadratischen Form eines gegebenen linearen Gleichungssystems. CG konvergiert nach 2 Schritten, die Größe… … Deutsch Wikipedia

CG-Verfahren — Ein Vergleich des einfachen Gradientenverfahren mit optimaler Schrittlänge (in grün) mit dem CG Verfahren (in rot) für die Minimierung der quadratischen Form eines gegebenen linearen Gleichungssystems. CG konvergiert nach 2 Schritten, die Größe… … Deutsch Wikipedia

Gradientenverfahren — Das Verfahren des steilsten Abstiegs, auch Gradientenverfahren genannt, ist ein Verfahren, das in der Numerik eingesetzt wird, um allgemeine Optimierungsprobleme zu lösen. Dabei geht man (am Beispiel eines Minimierungsproblemes) von einem… … Deutsch Wikipedia

Gradientenabstieg — Das Verfahren des steilsten Abstiegs, auch Gradientenverfahren genannt, ist ein Verfahren, das in der Numerik eingesetzt wird, um allgemeine Optimierungsprobleme zu lösen. Dabei geht man (am Beispiel eines Minimierungsproblemes) von einem… … Deutsch Wikipedia

Gradientenabstiegsverfahren — Das Verfahren des steilsten Abstiegs, auch Gradientenverfahren genannt, ist ein Verfahren, das in der Numerik eingesetzt wird, um allgemeine Optimierungsprobleme zu lösen. Dabei geht man (am Beispiel eines Minimierungsproblemes) von einem… … Deutsch Wikipedia

Methode der konjugierten Gradienten — Ein Vergleich des einfachen Gradientenverfahren mit optimaler Schrittlänge (in grün) mit dem CG Verfahren (in rot) für die Minimierung der quadratischen Form eines gegebenen linearen Gleichungssystems. CG konvergiert nach 2 Schritten, die Größe… … Deutsch Wikipedia

Kkt — Die Konvexe Optimierung ist ein Teilgebiet der mathematischen Optimierung. Es ist eine bestimmte Größe zu minimieren, die sogenannte Zielfunktion, welche von einem Parameter, welcher mit x bezeichnet wird, abhängt. Außerdem sind bestimmte… … Deutsch Wikipedia

Kuhn-Tucker-Bedingungen — Die Konvexe Optimierung ist ein Teilgebiet der mathematischen Optimierung. Es ist eine bestimmte Größe zu minimieren, die sogenannte Zielfunktion, welche von einem Parameter, welcher mit x bezeichnet wird, abhängt. Außerdem sind bestimmte… … Deutsch Wikipedia

Konvexe Optimierung — Die Konvexe Optimierung ist ein Teilgebiet der mathematischen Optimierung. Es ist eine bestimmte Größe zu minimieren, die sogenannte Zielfunktion, welche von einem Parameter, welcher mit x bezeichnet wird, abhängt. Außerdem sind bestimmte… … Deutsch Wikipedia

Delta-Regel — Der LMS Algorithmus (Least Mean Squares Algorithmus) ist ein Algorithmus zur Approximation der Lösung des Least Mean Squares Problems, das z. B. in der digitalen Signalverarbeitung vorkommt. In der Neuroinformatik ist der Algorithmus vor allem… … Deutsch Wikipedia

bestimmt, wobei

bestimmt, wobei  den Nabla-Operator bezeichnet. Dann wird wie folgt iteriert

den Nabla-Operator bezeichnet. Dann wird wie folgt iteriert

mit

mit